Wichtigste Erkenntnisse

- DeepSeek R1 ist ein chinesisches KI-Modell, das teilweise leistungsfähiger als ChatGPT ist.

- Man kann DeepSeek R1 lokal installieren. 100 % Privatsphäre inklusive.

- Für das 7B-Modell genügt ein moderner Standard-PC. Größere Modelle benötigen mehr RAM.

- Die Installation kann über die Kommandozeile oder mit grafischer Oberfläche erfolgen.

- Apps wie Apollo AI erlauben die Nutzung auf Handys

Inhaltsverzeichnis

Deepseek R1: Die neue KI-Revolution auf deinem Computer

DeepSeek R1 ist ein chinesisches KI-Modell, was vor kurzem veröffentlicht wurde. Es hat sehr schnell an Popularität gewonnen. Teilweise schneidet das Modell besser als ChatGPT O1 ab. Die besondere Stärke von DeepSeek R1: es ist ein Open-Source Modell. Du kannst es deshalb lokal auf deinem eigenen Computer ausführen.

Das Hauptmodell von DeepSeek R1 hat beeindruckende 671 Milliarden Parameter – das ist zu groß für normale Computer. Zum Glück gibt es kleinere Modelle, die auch auf normalen Computern laufen.

In diesem ausführlichen Guide zeige ich dir verschiedene Möglichkeiten, wie du DeepSeek R1 auf deinem Computer installieren und nutzen kannst.

Hier findest du eine ausführliche Beschreibung des DeepSeek Modells sowie seiner Besonderheiten.

Hardware-Voraussetzungen für DeepSeek R1: Was braucht dein Computer?

Bevor du DeepSeek R1 installierst, überprüfe bitte deine Hardware. Entscheidend ist die Größe deines Arbeitsspeichers (RAM), der Speicher deiner Grafikkarte und der freie Speicherplatz. Die Anforderungen hängen stark von der Größe des Modells ab, das du verwenden möchtest.

🧠 DeepSeek R1 Hardware-Checker

Finde heraus, welche DeepSeek R1 Modellgröße auf deinem Computer optimal läuft!

Ergebnis:

Nachfolgend findest du die verschiedenen Modelle sowie den notwendigen Arbeitsspeicher:

- 1,5B (1,5 Milliarden Parameter): Benötigt etwa 1 Gigabyte RAM, läuft auf fast jedem Computer und auf modernen Handys

- 7B (7 Milliarden Parameter): Benötigt etwa 8-10 GB RAM, läuft auf den meisten modernen Computern

- 14B (14 Milliarden Parameter): Benötigt etwa 16-20 GB RAM

- 32B (32 Milliarden Parameter): Benötigt etwa 32-40 GB RAM, besser als ChatGPT 4.0 (kostenlose Version)

- 70B (70 Milliarden Parameter): Benötigt etwa 70-80 GB RAM

- 671B (671 Milliarden Parameter): Benötigt Hunderte GB RAM, nicht für normale Computer geeignet

Meine persönliche Empfehlung: Wenn du einen Computer mit 16 GB RAM hast, verwende das 7B-Modell. Es bietet eine gute Balance zwischen Leistung und Ressourcenbedarf. Wenn du 32 GB RAM oder mehr hast, kannst du das 14B- oder sogar das 32B-Modell ausprobieren, das in vielen Fällen besser als ChatGPT 4.0 ist!

Neben dem RAM ist auch der Speicher der GPU (Grafikkarte) wichtig. Um so mehr, je größer das verwendete Modell ist. Eine NVIDIA RTX Grafikkarte kann durch ihre CUDA-Unterstützung die Ausführung erheblich beschleunigen. Aber auch Apple Silicon Prozessoren (M1, M2, M3) sind sehr effizient für KI-Workloads.

DeepSeek R1 mit Ollama installieren: Schritt-für-Schritt-Anleitung

Jetzt wird’s praktisch! Wir werden DeepSeek R1 mit Hilfe von Ollama installieren. Ollama ist ein fantastisches Tool, das dir hilft, KI-Modelle einfach herunterzuladen und lokal auszuführen.

Schritt 1: Ollama installieren

Ollama ist ein fantastisches Tool, das es dir erlaubt, KI-Modelle wie DeepSeek R1 einfach zu installieren und zu verwenden. Es kümmert sich um den Download und die Ausführung des Modells.

Installation auf macOS

- Öffne einen Browser und gehe zur Ollama-Website.

- Klicke auf “Download” und wähle “macOS”.

- Lade die .dmg-Datei herunter.

- Öffne die heruntergeladene Datei und ziehe das Ollama-Symbol in den “Programme”-Ordner.

- Öffne Ollama aus dem Programme-Ordner. Du solltest ein kleines Lama-Symbol in deiner Menüleiste sehen.

Installation auf Windows

- Besuche die Ollama-Website.

- Lade die Windows-Version herunter.

- Führe den Installer aus und folge den Anweisungen.

- Nach der Installation sollte Ollama automatisch im Hintergrund starten. Du findest es im System-Tray (rechts unten bei der Uhr).

Installation auf Linux

- Öffne ein Terminal-Fenster.

- Führe den folgenden Befehl aus:

curl -fsSL https://ollama.ai/install.sh | sh- Starte Ollama mit:

ollama serveSchritt 2: DeepSeek R1 herunterladen und einrichten

Nachdem Ollama installiert und gestartet ist, kann das DeepSeek R1 Modell heruntergeladen werden:

- Öffne ein Terminal-Fenster:

- macOS: Drücke Cmd+Leertaste, tippe “Terminal” und drücke Enter

- Windows: Drücke Windows+R, tippe “cmd” und drücke Enter

- Linux: Drücke Ctrl+Alt+T oder nutze dein Terminal-Programm

- Gib folgenden Befehl ein, um das DeepSeek R1 7B-Modell herunterzuladen (oder wähle eine andere Größe, je nach deiner Hardware)

ollama pull deepseek-r1:7bFür leistungsstärkere Computer kannst du größere Modelle wählen:

ollama pull deepseek-r1:14bollama pull deepseek-r1:32b- Warte, bis der Download abgeschlossen ist. Dies kann einige Minuten bis Stunden dauern, je nach Internetgeschwindigkeit und Modellgröße.

Schritt 3: DeepSeek R1 ausführen

Sobald das Modell heruntergeladen ist, kannst du es starten:

- Im Terminal gib ein:

ollama run deepseek-r1:xxErsetze xx durch die Modellgröße, die du heruntergeladen hast (7b, 14b, 32b etc.)

- Du siehst nun eine Eingabeaufforderung. Hier kannst du Fragen stellen oder Aufgaben formulieren:

>>> Löse diese Gleichung: 3x + 7 = 28- DeepSeek R1 wird antworten. Das Besondere: Bei komplexen Fragen siehst du zunächst den Denkprozess (mit dem Tag “thinking”), bevor die endgültige Antwort kommt.

Anpassen des Modellverhaltens

Du kannst das Verhalten des Modells mit speziellen Parametern anpassen. Zum Beispiel:

ollama run deepseek-r1:7b --temperature 0.2Die Temperature steuert die Kreativität des Modells. Niedrigere Werte (nahe 0) führen zu konsistenteren, weniger kreativen Antworten, während höhere Werte (maximal 1) kreativere Antworten erzeugen.

Eine benutzerfreundliche Oberfläche mit AnythingLLM einrichten

Das Terminal ist nicht für jeden Anwender die beste Umgebung. Zum Glück gibt es mit AnythingLLM eine benutzerfreundliche grafische Benutzeroberfläche, mit der du DeepSeek R1 wie einen normalen Chat-Client nutzen kannst.

Schritt 1: AnythingLLM herunterladen und installieren

Installation für macOS:

- Besuche die AnythingLLM GitHub-Seite

- Lade die macOS-Version herunter (endet mit

.dmg) - Öffne die heruntergeladene .dmg-Datei

- Ziehe das AnythingLLM-Symbol in deinen Programme-Ordner

- Öffne AnythingLLM aus dem Programme-Ordner

- Bei einer Sicherheitswarnung: Öffne die Systemeinstellungen → Sicherheit & Datenschutz → klicke auf “Öffnen erlauben”

Installation für Windows:

- Besuche die offizielle AnythingLLM GitHub-Seite

- Scrolle zur neuesten Version und lade die Windows-Datei herunter (endet mit

.exe) - Führe die heruntergeladene .exe-Datei aus

- Folge dem Installationsassistenten

- Nach der Installation sollte AnythingLLM automatisch starten

Installation für Linux:

- Besuche die AnythingLLM GitHub-Seite

- Lade die Linux-Version herunter (endet mit

.AppImage) - Öffne ein Terminal an dem Ort, wo die Datei gespeichert ist

- Mache die Datei ausführbar:

chmod +x AnythingLLM*.AppImage- Führe die AppImage-Datei aus:

./AnythingLLM*.AppImageSchritt 2: Ersteinrichtung von AnythingLLM

Wenn du AnythingLLM zum ersten Mal startest, siehst du einen Einrichtungsassistenten:

- Wähle deine Sprache (idealerweise Deutsch oder Englisch)

- Wähle die lokale Installation (nicht die Cloud-Version)

- Erstelle einen Nutzernamen und ein Passwort für den Admin-Zugang

- Diese Daten werden nur lokal gespeichert und schützen deinen Zugang

- Vergiss dein Passwort nicht!

- Klicke auf “Einrichtung abschließen”

- Du wirst automatisch in das AnythingLLM-Dashboard weitergeleitet

Schritt 3: Workspace erstellen für DeepSeek R1

- Klicke in der linken Seitenleiste auf “Neuer Workspace”

- Gib deinem Workspace einen Namen (z.B. “DeepSeek R1 Chat”)

- Optional: Füge eine Beschreibung hinzu

- Lass die anderen Einstellungen erstmal unverändert

- Klicke auf “Workspace erstellen”

Schritt 4: DeepSeek R1 in AnythingLLM einrichten

Jetzt kommt der wichtigste Teil – die Verbindung zu DeepSeek R1:

- Klicke in deinem neuen Workspace auf das Zahnrad-Symbol ⚙️ (rechts oben in der Workspace-Karte)

- Scrolle nach unten zum Abschnitt “LLM-Einstellungen”

- Wähle bei “LLM-Provider” die Option “Ollama” aus

- Bei “Ollama URL” gibst du ein:

http://localhost:11434- Bei “Ollama Modell” wähle dein installiertes DeepSeek R1-Modell aus der Dropdown-Liste:

deepseek-r1:7b(oder die Version, die du installiert hast)- Falls das Modell nicht angezeigt wird, stelle sicher, dass Ollama läuft und das Modell installiert ist

- Passe folgende Einstellungen an:

- Temperature: 0.1 bis 0.3 für logische Antworten, 0.7 bis 0.9 für kreativere Antworten

- System Prompt: Hier kannst du Anweisungen für das Modell hinterlegen, z.B.:Copy code

Du bist DeepSeek R1, ein hilfreicher, respektvoller und ehrlicher KI-Assistent. Beantworte die Fragen des Nutzers so genau und hilfreich wie möglich. Wenn du etwas nicht weißt, gib das zu, anstatt falsche Informationen zu erfinden.

- Scrolle nach unten und klicke auf “Speichern”

Schritt 5: DeepSeek R1 über AnythingLLM nutzen

Jetzt kannst du mit DeepSeek R1 über die benutzerfreundliche Oberfläche von AnythingLLM kommunizieren:

- Klicke auf deinen Workspace, um ihn zu öffnen.

- Du siehst nun die Chat-Oberfläche.

- Unten befindet sich ein Eingabefeld, in das du deine Fragen oder Anweisungen eingeben kannst.

- Tippe eine Nachricht ein, z.B.:

Kannst du mir erklären, was ein Reasoning-Modell ist und was DeepSeek R1 besonders macht?- Drücke die Eingabetaste oder klicke auf den Senden-Button.

DeepSeek R1 wird nun deine Frage verarbeiten und antworten. Da die Verarbeitung lokal auf deinem Computer erfolgt, kann dies je nach Modellgröße und Hardware einige Sekunden bis Minuten dauern.

Dokumenten-Upload (optional)

Ein großartiges Feature von AnythingLLM ist die Möglichkeit, Dokumente hochzuladen und DeepSeek R1 darauf zugreifen zu lassen:

- Gehe in deinen Workspace

- Klicke auf den Button “Dokumente” (oder “Documents”) in der oberen Leiste

- Klicke auf “Dokument hochladen”

- Wähle eine PDF-, TXT- oder DOCX-Datei aus

- Nach dem Upload wird das Dokument verarbeitet und in Chunks aufgeteilt

- Jetzt kannst du im Chat Fragen zu dem Dokument stellen, z.B.:

Kannst du mir eine Zusammenfassung des Dokuments geben, das ich gerade hochgeladen habe?Lokale Installation mit Pinokio

Schritt 1: Pinokio herunterladen und installieren

- Öffne deinen Browser und gehe zur offiziellen Pinokio-Website

- Klicke auf den “Download”-Button und wähle die Version für dein Betriebssystem:

- Windows:

.exeDatei - macOS:

.dmgDatei - Linux:

.AppImageDatei

- Windows:

Installation für macOS:

- Öffne die heruntergeladene

.dmg-Datei - Ziehe das Pinokio-Symbol in deinen Programme-Ordner

- Öffne Pinokio aus dem Programme-Ordner

- Bei Sicherheitswarnungen: Öffne Systemeinstellungen → Sicherheit & Datenschutz → Klicke auf “Trotzdem öffnen”

Installation für Windows:

- Führe die heruntergeladene

.exe-Datei aus - Wenn eine Sicherheitswarnung erscheint, klicke auf “Weitere Informationen” und dann “Trotzdem ausführen”

- Folge dem Installationsassistenten und akzeptiere die Standard-Einstellungen

- Nach Abschluss der Installation startet Pinokio automatisch

Installation für Linux:

- Mache die heruntergeladene

.AppImage-Datei ausführbar:

chmod +x Pinokio*.AppImage- Starte die Anwendung mit:

./Pinokio*.AppImageSchritt 2: Erste Einrichtung von Pinokio

Wenn Pinokio zum ersten Mal startet, öffnet sich ein Browserfenster mit der Pinokio-Benutzeroberfläche:

- Du siehst die Pinokio-Startseite mit verschiedenen App-Karten

- Wichtig: Pinokio läuft als lokaler Server auf deinem Computer, ist aber über den Browser zugänglich

- Die Standard-Adresse ist

http://localhost:6060– merke dir diese für später

Schritt 3: DeepSeek R1 über Pinokio installieren

So installierst du DeepSeek R1:

- In der Pinokio-Benutzeroberfläche, suche nach “DeepSeek” im Suchfeld oben oder scrolle durch die verfügbaren Apps

- Klicke auf die Karte “DeepSeek R1 Chat” (oder ähnlicher Name, je nach aktueller Version)

- Klicke auf den “Install”-Button

- Pinokio zeigt dir einen Installationsbildschirm mit Details zu DeepSeek R1

- Klicke auf “Start Installation”

- Pinokio beginnt nun automatisch:

- Die notwendigen Pakete herunterzuladen

- Python-Umgebung einzurichten

- DeepSeek R1 zu installieren

- Abhängigkeiten zu konfigurieren

- Während der Installation wirst du aufgefordert, eine Modellgröße auszuwählen.

- Der Download des Modells beginnt. Dies kann je nach Modellgröße und Internetgeschwindigkeit 5-30 Minuten dauern.

- Nach Abschluss des Downloads wird das Modell automatisch entpackt und konfiguriert.

- Pinokio zeigt die Meldung “Installation completed” an, wenn alles erfolgreich war.

Schritt 4: DeepSeek R1 in Pinokio starten und nutzen

Jetzt ist alles bereit, um DeepSeek R1 zu starten:

- Gehe zur Pinokio-Hauptseite, indem du auf “Home” oder das Pinokio-Logo klickst

- Suche die Karte “DeepSeek R1 Chat” und klicke darauf

- Klicke auf den “Run”-Button (oder “Start”, je nach Version)

- Pinokio startet nun das DeepSeek R1 Modell im Hintergrund

- Nach 10-30 Sekunden (je nach Hardware) öffnet sich die Chat-Oberfläche

Grundlegende Verwendung:

- In der Chat-Oberfläche siehst du ein Eingabefeld am unteren Rand

- Gib deine Frage oder Anweisung ein, z.B.:

Erkläre mir, was DeepSeek R1 ist und worin es sich von anderen KI-Modellen unterscheidet.- Drücke Enter oder klicke auf den Senden-Button

DeepSeek R1 beginnt nun mit der Verarbeitung deiner Anfrage

Andere Optionen zur lokalen Installation von DeepSeek R1

Es noch weitere Möglichkeiten, DeepSeek R1 lokal zu installieren und zu nutzen:

LM Studio

LM Studio ist eine Anwendung mit einer benutzerfreundlichen Oberfläche, die das Ausführen von KI-Modellen auf deinem Computer erleichtert. Es unterstützt verschiedene DeepSeek R1 Modellgrößen und bietet eine Chat-Oberfläche.

Installation:

- Besuche die LM Studio Website und lade die Anwendung für dein Betriebssystem herunter

- Installiere und starte LM Studio

- Gehe zum “Models”-Tab und suche nach “DeepSeek R1”

- Lade die gewünschte Modellgröße herunter

- Starte einen Chat mit dem heruntergeladenen Modell

Text Generation WebUI

Dieses Open-Source-Projekt bietet eine umfangreiche Weboberfläche zum Ausführen von Sprachmodellen lokal. Es ist etwas komplexer einzurichten, bietet aber viele Anpassungsmöglichkeiten.

Installation:

- Clone das GitHub-Repository oder lade es hier herunter

- Installiere die erforderlichen Abhängigkeiten mit pip

- Starte die Anwendung und öffne sie im Browser

- Lade das DeepSeek R1 Modell herunter und konfiguriere es

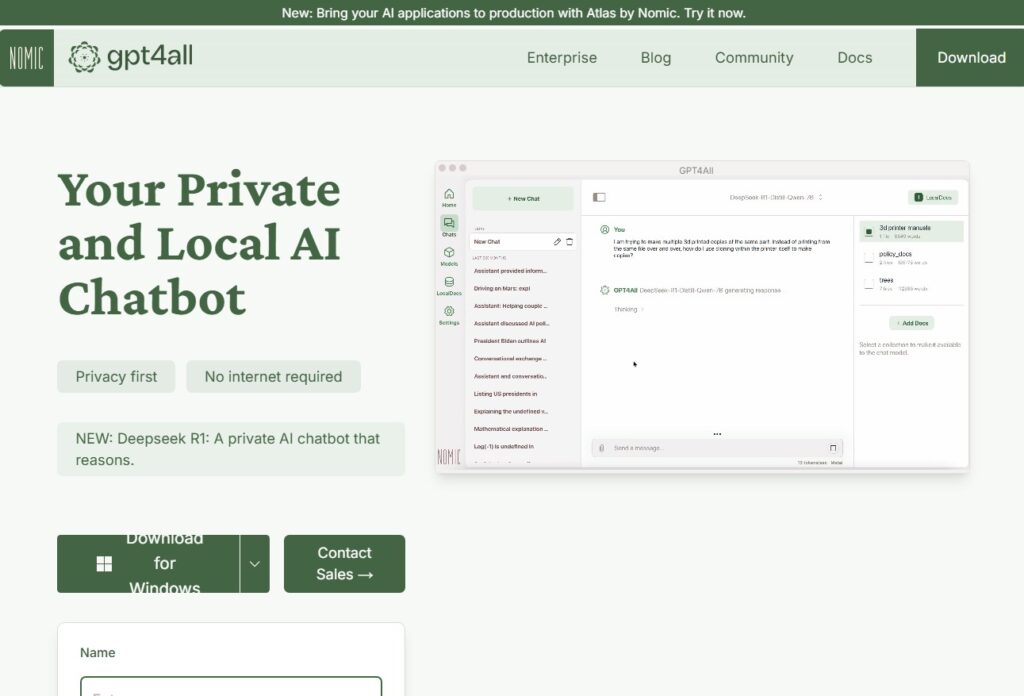

GPT4All

GPT4All ist eine Plattform, die das lokale Ausführen verschiedener Sprachmodelle ermöglicht, einschließlich DeepSeek R1.

Installation:

- Lade GPT4All von der offiziellen Website herunter

- Installiere die Anwendung

- Öffne GPT4All und gehe zum “Models”-Tab

- Suche nach “DeepSeek R1” und lade das gewünschte Modell herunter

- Starte einen Chat mit dem Modell

Häufig gestellte Fragen zur lokalen Installation von DeepSeek

Ist DeepSeek R1 wirklich kostenlos?

Ja, DeepSeek R1 ist ein Open-Source-Modell und kann kostenlos heruntergeladen und genutzt werden. Du musst nur für die Hardware bezahlen, auf der du es ausführen möchtest.

Wie viel Festplattenspeicher benötige ich für DeepSeek R1?

Das hängt von der Modellgröße ab. Das 7B-Modell benötigt etwa 8-10 GB Speicherplatz, das 32B-Modell etwa 32-40 GB und das 70B-Modell etwa 70-80 GB.

Kann ich DeepSeek R1 mit einer schwachen Grafikkarte nutzen?

Ja, das ist möglich, aber es wird langsamer sein. Für das 7B-Modell reicht auch die CPU, für größere Modelle wird eine dedizierte GPU empfohlen, vorzugsweise eine NVIDIA RTX mit mindestens 8 GB VRAM.

Wie schnell antwortet DeepSeek R1 auf meinem Computer?

Die Geschwindigkeit hängt von deiner Hardware und der Modellgröße ab. Mit dem 7B-Modell auf einer modernen CPU kannst du etwa 10-15 Tokens (etwa 7-10 Wörter) pro Sekunde erwarten. Mit dem 32B-Modell auf einer starken GPU etwa 5-10 Tokens pro Sekunde.

Schreibe einen Kommentar